spark-shell on yarn模式 启动不了

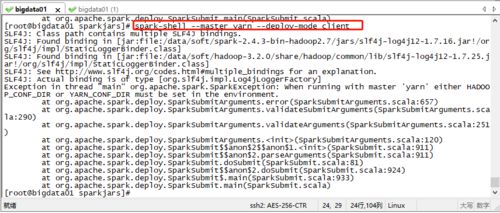

spark-shell on yarn模式 启动不了,报下边的错误

相关代码:

SLF4J: Class path contains multiple SLF4J bindings. SLF4J: Found binding in [jar:file:/data/soft/spark-2.4.3-bin-hadoop2.7/jars/slf4j-log4j12-1.7.16.jar!/org/slf4j/impl/StaticLoggerBinder.class] SLF4J: Found binding in [jar:file:/data/soft/hadoop-3.2.0/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class] SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation. SLF4J: Actual binding is of type [org.slf4j.impl.Log4jLoggerFactory] Exception in thread "main" org.apache.spark.SparkException: When running with master 'yarn' either HADOOP_CONF_DIR or YARN_CONF_DIR must be set in the environment. at org.apache.spark.deploy.SparkSubmitArguments.error(SparkSubmitArguments.scala:657) at org.apache.spark.deploy.SparkSubmitArguments.validateSubmitArguments(SparkSubmitArguments.scala:290) at org.apache.spark.deploy.SparkSubmitArguments.validateArguments(SparkSubmitArguments.scala:251) at org.apache.spark.deploy.SparkSubmitArguments.<init>(SparkSubmitArguments.scala:120) at org.apache.spark.deploy.SparkSubmit$$anon$2$$anon$1.<init>(SparkSubmit.scala:911) at org.apache.spark.deploy.SparkSubmit$$anon$2.parseArguments(SparkSubmit.scala:911) at org.apache.spark.deploy.SparkSubmit.doSubmit(SparkSubmit.scala:81) at org.apache.spark.deploy.SparkSubmit$$anon$2.doSubmit(SparkSubmit.scala:924) at org.apache.spark.deploy.SparkSubmit$.main(SparkSubmit.scala:933) at org.apache.spark.deploy.SparkSubmit.main(SparkSubmit.scala)

15

收起

正在回答

1回答

核心错误日志是这一句。

Exception in thread "main" org.apache.spark.SparkException: When running with master 'yarn' either HADOOP_CONF_DIR or YARN_CONF_DIR must be set in the environment.

里面说HADOOP_CONF_DIR 或者 YARN_CONF_DIR 必须至少在环境变量中配置一个。

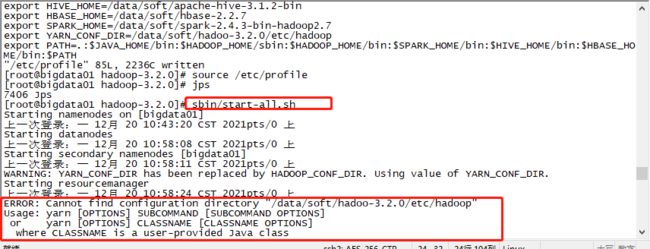

你应该是忘记在这台机器上配置HADOOP_HOME环境变量了,课程中只配置了这个就行了。你先在/etc/profile中配置一下这个,然后source一下环境变量,再验证。

如果配置完HADOOP_HOME还不行,就需要配置HADOOP_CONF_DIR 或者 YARN_CONF_DIR 了。

HADOOP_CONF_DIR 或者 YARN_CONF_DIR 的值对应的是/data/soft/hadoo-3.2.0/etc/hadoop

相似问题

登录后可查看更多问答,登录/注册

恭喜解决一个难题,获得1积分~

来为老师/同学的回答评分吧

0 星