encoder和decoder的理解

seq2seq的过程可以理解成自然语言通过encoder转化成大模型的映射,然后大模型拿到映射在通过decoder输出成为自然语言吗?

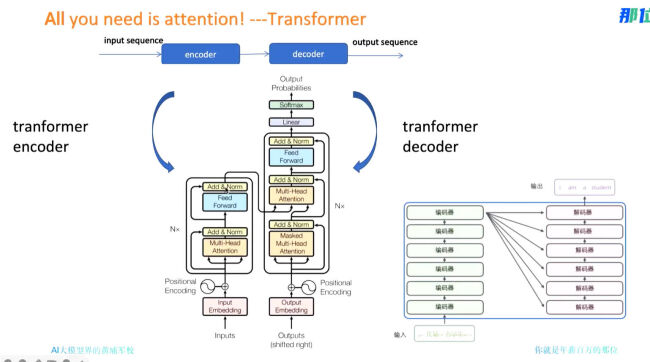

相关截图:

正在回答

是的。输出序列,这个序列的生成就是一个个预测的最大概率单词组成。seq2seq(Sequence-to-Sequence)模型是一种常用于机器翻译、文本摘要、问答系统等自然语言处理任务的模型。它的核心思想是将输入序列(如一种语言的句子)转换成固定长度的内部表示(编码),然后再将这个内部表示转换成输出序列(如另一种语言的句子)。在这个过程中,主要涉及到两个关键组件:encoder和decoder。

1. Encoder:encoder负责读取输入序列(例如,一个英语句子),并将其转换成一个固定大小的内部表示,这个内部表示捕捉了输入数据的主要信息。在seq2seq模型中,encoder通常是一个循环神经网络(RNN)或者是一个Transformer模型的编码器部分,它能够处理输入序列并生成一个上下文向量(context vector)。

2. Decoder:decoder则负责将encoder生成的内部表示转换成输出序列(例如,一个法语句子)。它通常也是一个循环神经网络或者Transformer模型的解码器部分,它使用encoder的输出作为初始状态,并逐步生成输出序列。

Transformer”模型中,encoder和decoder都是基于自注意力(self-attention)机制构建的,这种机制允许模型在处理序列的任意位置时都能够考虑到整个序列的信息,从而提高了模型处理长距离依赖的能力。

简而言之,seq2seq模型的工作流程可以概括为:

● 输入序列通过encoder转换成内部表示。

● decoder使用这个内部表示来生成输出序列。

- 参与学习 90 人

16大真实多领域全流程实战,轻松应对AI大模型多领域核心问题,全面覆盖Chatgpt、langchain、多模态、RAG、Agent、微调,从学习到内推服务,专注培养AI大模型全能实战专家的黄埔军校

了解课程

恭喜解决一个难题,获得1积分~

来为老师/同学的回答评分吧

0 星